Les géants du Net sont les nouveaux gatekeepers de l’information en ligne, créant ainsi les conditions d’une distribution « virale » des nouvelles. En faisant de la personnalisation des services une règle, véritablement Google et Facebook ont inventé « l’information sur mesure de masse ».

Fustigeant la dépendance de la presse vis-à-vis de la publicité, le manifeste de Laurent Beccaria et Patrick de Saint-Exupéry publié dans leur revue XXI ( hiver 2013 ) titrant « Un autre journalisme est possible » et « Un journalisme utile » paraît négliger l’impératif économique du maintien d’un prix de vente des journaux accessible au plus grand nombre, ou encore la naissance de médias audiovisuels commerciaux financés essentiellement par les annonceurs. En permettant de baisser leur prix de vente, l’introduction de la publicité dans les journaux au XIXe siècle a rendu l’information accessible à tous. La presse n’a jamais appartenu qu’aux seuls journalistes : elle a toujours été dépendante des pouvoirs quels qu’ils soient, institutionnels, politiques ou économiques. Le recours au financement publicitaire n’est certes pas un modèle parfait, sans risques quant à la liberté d’informer, comme le démontre de façon toujours plus évidente l’existence de frontières de plus en plus floues entre l’information et la communication. En mai 2013, l’annonce par le groupe Lagardère du lancement d’une nouvelle offre commerciale de native advertising renforce cette suspicion de dépendance. Venue des Etats-Unis où le magazine Forbes, le quotidien The Washington Post et le pure-player Huffington Post.com l’ont déjà adoptée, cette nouvelle forme de publireportage ouvre les colonnes des journaux à des contenus rédigés par les annonceurs eux- mêmes, adoptant le ton et la forme du support qui les accueille. Il en va dans ce cas précis de la responsabilité des éditeurs de médias s’agissant des dérives potentielles de ce genre de pratiques. Aussi stérile que soit le parti pris d’opposer l’imprimé et le Web, la tradition et la modernité – la qualité, le sérieux, le professionnalisme du journalisme ne relevant pas de la technique employée –, on ne peut cependant manquer de s’interroger sur les conséquences de l’engouement dont bénéficient certains services numériques sur le marché de l’information, et donc sur leur finalité.

Les géants du Net ont tissé la Toile :

– 70 % des requêtes mondiales sur l’Internet fixe passent par Google (entre 2002 et 2012, la part de marché du moteur de recherche est passée de moins de 20 % à plus de 90 % en France,à l’instar de l’Allemagne, de l’Espagne et du Royaume- Uni).

– 95 % des requêtes effectuées depuis un terminal mobile reviennent à Google grâce à l’intégration de son moteur de recherche dans son système d’exploitation Android qui équipe 900 millions de terminaux mobiles (+ 100 % par rapport à 2012) et à son installation par défaut sur les appareils d’Apple, iPhone et iPad.

– Avec 25 % de part de marché, Google Chrome est devenu en décembre 2012 le deuxième navigateur le plus utilisé en Europe, après Internet Explorer de Microsoft qui ne détient plus que 30 % du marché en janvier 2013 contre plus de 40 % en janvier 2012.

– Plus d’un internaute sur deux dans le monde utilise Facebook.

– Le plus grand réseau social du monde compte presque autant de membres que la Chine ou l’Inde n’ont chacun d’habitants.

Passés maîtres de la numérisation des usages, Google et Facebook prennent la main sur la circulation des contenus. Dans un ouvrage intitulé The Filter Bubble : What the Internet Is Hiding from You, paru en 2011, l’Américain Eli Pariser explique comment les internautes sont « piégés dans une bulle de filtres », l’ensemble des algorithmes, qui les prémunit contre les informations contraires à leur propre vision du monde. L’auteur y voit un danger pour la démocratie : il donne notamment en exemple la suppression à son insu de tous les liens postés par ses amis conservateurs sur sa page Facebook après que l’algorithme du réseau social a repéré qu’il cliquait plus souvent sur les liens de ses amis libéraux (conférence TED, The Filter Bubble).

L’internaute est ROI ( Return On Investment)

La véritable menace, nouvelle, plus redoutable car insidieuse, provient du déploiement des techniques marketing nées d’Internet. L’adoption d’une succession ininterrompue et rapide de nouveaux outils influe sur la distribution des contenus sur Internet et en conditionne donc l’accès. Sans nier l’incontestable apport des outils numériques en termes d’usages, il est sans nul doute légitime de s’interroger sur leur impact sur la distribution de l’information. Avec une philosophie d’emprunt, les groupes, tous américains, qui dominent Internet, assurent agir pour le bien de tous en offrant un accès facile, permanent et immédiat, à l’ensemble des contenus diffusés sur le réseau mondial. Comme le dit si bien le chercheur et éditorialiste Evgeny Morozov, l’entreprise commerciale Google « rassure tout le monde avec le discours d’une ONG ». Plaçant l’individu au cœur de leur système, les groupes internet tirent leur puissance de leur capacité à générer du trafic – et donc des revenus publicitaires qui composent la quasi- totalité de leur chiffre d’affaires – en inventant des usages numériques dont ils prennent le contrôle. En apportant toujours plus de confort quotidien aux internautes, Facebook, Apple, Google, Twitter et Amazon dirigent ainsi la vie en ligne en détenant les clés de l’accès au réseau et donc aux contenus qu’il diffuse.

Au XXIe siècle, les technologies numériques, et plus particulièrement les méthodes marketing afférentes, entraînent une « hyperindividualisation » des modes de consommation de l’information. Depuis les premiers flux RSS jusqu’à la géolocalisation, l’information pour tous s’est transformée peu à peu en une information personnalisée. L’information destinée à tous distribuée par les médias traditionnels devient sur Internet l’information pour chacun. En délivrant aux individus des informations conformes à l’expression de leurs intérêts, le plus souvent d’une manière implicite, les requêtes, les recommandations, les partages, les « j’aime » canalisent les flux. L’individualisation des usages ne contribue pas à apporter davantage de choix à chaque individu, mais plutôt à le conforter dans ses habitudes. Une pseudo-personnalisation de l’information intensifie au contraire sur Internet la massification de l’information, dans la mesure où les mêmes contenus circulent entre un grand nombre de personnes. Individualiser les modes de distribution ne signifie pas offrir des contenus singuliers.

En donnant le premier rôle à l’individu connecté, la puissance des géants du Net réside dans leur capacité à se substituer aux producteurs de contenus dans la distribution de leur production. Les followers ne sont pas ceux que l’on croit. En adoptant spontanément, pour ne pas dire aveuglément, l’ensemble des instruments numériques inventés par les groupes internet, les responsables des médias y ont perdu leur autonomie. Puisque manquer une étape de la révolution numérique reviendrait immédiatement à se couper du monde, ils ont délégué par voie de conséquence la gestion de l’accès aux contenus à des groupes dont la préoccupation première est la rentabilité financière des services qu’ils proposent. Google et Facebook n’ont pourtant pas vocation à donner à tous accès à l’information mais à jouer le rôle d’intermédiaire technologique contre rémunération. Lorsque Google concède généreusement 60 millions d’euros d’aides à la presse française, il s’engage également à aider les entreprises de presse à mieux utiliser ses propres outils marketing. Don’t be evil !

Dans son cahier de tendances, Méta-média #3 (printemps-été 2012), Eric Scherer rapporte le conseil que Richard Gingras, à la tête de Google News – un milliard de lecteurs par semaine d’articles de presse en provenance de 72 pays et en 45 langues – a adressé à une soixantaine de responsables de médias du monde entier réunis à Madrid en avril 2012 : « Vous devriez repenser le modèle tout pour tout le monde », ainsi que celui énoncé par Vadim Lavrusik, responsable du programme Journalisme de Facebook : « Votre manière de collecter et de présenter l’information est trop traditionnelle. Vous devriez plus travailler la manière dont vous présentez l’information afin d’attirer davantage l’attention des gens. Car l’attention va être dans les dix ans à venir l’une des sources rares. […] Nous n’avons pas besoin de plus d’articles, mais d’articles plus efficaces ». Ces propos émanant de deux décideurs d’Internet illustrent précisément la tendance prise par l’information sur Internet à mesure que se multiplient les outils d’individualisation des usages. Initialement grâce aux moteurs de recherche, suivis des réseaux sociaux et aujourd’hui de l’Internet mobile, l’internaute, caractérisé par son historique de navigation, ses requêtes, ses profils, sa géolocalisation, se voit offrir sur Internet, sans pouvoir y renoncer facile- ment, une information de plus en plus personnalisée.

L’information personnalisée

Au tournant des années 2000, les journaux proposent des services personnalisés de distribution de l’information afin d’attirer les lecteurs sur leur site web : personnalisation de la page d’accueil, alerte par courrier électronique, liste de diffusion, lettre d’information, flux RSS. Ces pratiques en mode push contribuent à fidéliser les internautes en les informant sur les sujets de leur choix. Pour ne pas rester en marge du Web, les éditeurs adoptent ensuite une stratégie d’optimisation pour les moteurs de recherche, SEO (Search Engine Optimization) ou « référencement naturel », en introduisant notamment des mots clés dans le titre des articles conformément à la logique marketing du référencement sur Internet. Les algorithmes établis par les moteurs de recherche, dont la formule est tenue secrète, affichent des résultats reflétant la popularité des contenus sur le Web (le fameux PageRank inventé par Google basé sur l’exploitation des liens hypertextes). Le moteur de recherche Google sert ainsi de guide aux internautes en quête d’information, en proposant des résultats conformes à leur historique de navigation. De même, en associant automatiquement des termes à la saisie d’une requête, la fonction Google Suggest accompagne encore davantage l’internaute dans sa recherche d’information. L’agrégateur de sources d’information Google Actualités, dont l’algorithme accorde la primeur aux médias traditionnels sur les pure players, permet également aux internautes détenant un compte Google de créer une page personnalisée avec leurs propres rubriques par mots clés ou localités.

L’information recommandée

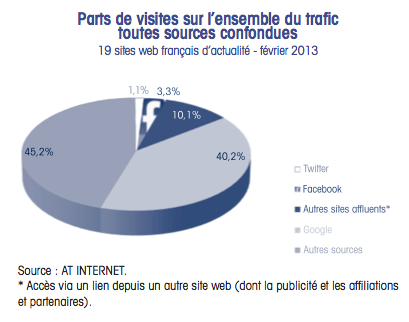

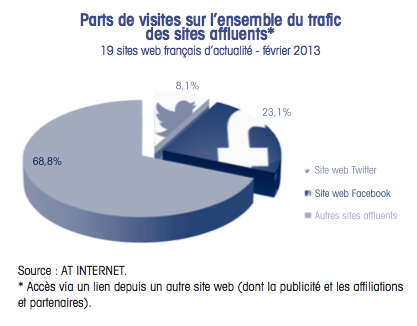

A partir de 2010, les réseaux sociaux vont fortement accentuer cette tendance à la personnalisation de la distribution de l’information en faisant de la recommandation le principal filtre des échanges de contenus sur Internet. Sur Facebook comme sur Twitter, les contenus bénéficiant du plus grand nombre de recommandations sont mis en avant. Sur les réseaux sociaux, l’agenda médiatique est établi à partir des contenus les plus souvent relayés. En 2010, l’Open Graph de Facebook établit un lien systématique entre la navigation des internautes sur le Web et leur profil Facebook, en les invitant à partager avec leurs amis, d’un clic sur le bouton « j’aime », les contenus qu’ils apprécient. Présentée en septembre 2011, la nouvelle version d’Open Graph est complétée par une multitude de fonctionnalités (social plugins), « je lis », « je regarde », « j’écoute», « je joue ». Une fois activé par l’internaute, l’Open Graph 2.0 publie automatiquement et en temps réel sur son profil Facebook, chacune de ses activités sur divers sites. En complément de leurs pratiques SEO, les médias se sont donc également convertis spontanément aux techniques de l’optimisation pour les médias sociaux, SMO (Social Media Optimization) ou référencement social. Adoptée par nombre de grands quotidiens d’information, l’application de lecture sociale (social reader) permet ainsi de construire sa propre « Une », affichant les contenus des rubriques les plus souvent consultées, ainsi que les articles lus par ses amis. L’information est désormais distribuée, donc découverte, au gré des commentaires et des partages au sein d’une communauté d’amis, définie par Facebook. En développant des applications d’identification et de partage pour des sites tiers, le réseau social entretient la « viralité » de l’information, procurant davantage de visibilité sur le Web aux « marques » de médias. L’intégration d’applications médias fait de Facebook une des plaques tournantes (hub) d’Internet. Ces outils de recommandation participent à la hiérarchisation des événements, orientant ainsi la « consommation » d’information des internautes. S’inspirant de la lettre d’information LinkedIn Today diffusée à ses membres par le réseau social professionnel LinkedIn, Facebook a enrichi son fil d’actualités, en avril 2012, avec une sélection d’articles lus par les amis. Depuis 2012, Google a enrichi son moteur de recherche avec des résultats personnalisés réservés aux titulaires d’un compte maison, en intégrant des contenus publiés sur son réseau social Google+. En intensifiant leur présence sur les réseaux sociaux, les médias tentent d’accaparer un peu du temps passé par leurs membres. La suggestion de lecture personnalisée, adaptée au profil de l’utilisateur et à celui de ses amis, se répand comme un virus informatique sur Internet. En organisant le flux des nouvelles, la lecture sociale change indéniablement la façon de s’informer sur le Web. Communiquer à ses amis l’intérêt porté à tel article ou tel sujet revient à confier au réseau social la diffusion de l’information.

Les médias eux-mêmes établissent une hiérarchisation sociale de l’information correspondant aux choix des internautes. Certains mettent en exergue les contributions bénéficiant du plus grand nombre de recommandations sur Facebook et ainsi attribuent le statut de top editors à leurs auteurs. D’autres encouragent leurs lecteurs internautes à recommander les articles de leur choix. La liste des articles les plus partagés sur le réseau social figure souvent en bonne place sur leur page d’accueil.

En septembre 2012, l’algorithme Edgerank, qui détermine la visibilité des posts reçus sur le fil d’actualité des membres de Facebook, a été modifié afin de privilégier les publications générant un taux d’engagement élevé (nombre de clics, de « j’aime », de commentaires ou de partages) en les distribuant aux membres les plus actifs. De nouvelles options de ciblage sont mises à la disposition des administrateurs web : âge, sexe, situation amoureuse, formation, intéressé(e) par, lieu de résidence, langue. Les médias peuvent s’interroger sur la pertinence de cette hiérarchisation algorithmique de l’information dictée par les intérêts présumés des internautes sur Facebook. Sur son blog Rezonances en date du 12 octobre 2012, le quotidien Le Monde est le premier à s’inquiéter de l’inadéquation entre ce filtrage marketing établi par Facebook et sa ligne éditoriale sur le réseau social. Cette personnalisation du flux d’actualité revient à créer pour chacun sur Facebook un « journal » qui lui ressemble. En outre, Facebook offre aux entreprises la possibilité de payer pour rendre leurs publications plus visibles.

L’information recomposée

Avec le développement spectaculaire de l’Internet mobile, l’audience sur les terminaux portables représente déjà un tiers de l’audience internet pour certains médias, davantage encore pour d’autres. Les usages en mobilité participent eux aussi à la distribution d’une information « sur mesure », grâce aux nombreuses applications offrant des services personnalisés. Agrégeant à la fois articles de presse, photos, vidéos, morceaux de musique, fils de réseaux sociaux, l’application Flipboard recompose pour chacun son magazine à feuilleter. Se présentant comme le « Deezer de la presse », à la fois agrégateur d’information et kiosque numérique, Youmag permet à l’utilisateur d’élaborer sa propre revue de presse à partir de 5 000 sources.

L’information géolocalisée

Les techniques de géolocalisation renforcent encore cette tendance à la spécialisation. Grâce aux outils de navigation (GPS, Global Positioning System) et de cartographie intégrés aux smartphones, l’envoi de messages promotionnels ciblés aux mobinautes, en fonction du lieu où ils se trouvent, sera bientôt une pratique commerciale courante. Les services de géolocalisation (« Latitude » de Google, « Localiser mes amis » d’Apple, « Trouver ses amis à proximité » de Facebook) deviendront alors des supports de diffusion utiles aux journaux locaux, en associant leurs contenus aux publicités ciblées.

Lancée en 2010, l’application de géolocalisation permanente Google Now fait partie des services innovants éminemment « prometteurs ». Cet assistant numérique collecte et exploite les données personnelles de son utilisateur enregistrées par les différents services en ligne de Google (Chrome, Gmail, Google Agenda…), afin de lui adresser automatiquement, au moment opportun, des informations pratiques, conditions météorologiques, temps de trajet, trafic routier… Associant services et données personnelles, cette application laisse imaginer ce que sera la robotisation croissante de l’accès à l’information.

Des applications mobiles de géolocalisation permettant de savoir d’où a été posté un message et de le partager avec les amis aux alentours intéresseront à terme les éditeurs d’information de proximité. Un nouveau service baptisé Ujoolt permet de consulter en temps réel, sur une carte géographique, les textes courts, photos ou brèves vidéos (les jolts) postés au cours des quatre dernières heures par ses utilisateurs situés dans un rayon d’un kilomètre.

A ce palmarès des technologies « d’individualisation de la diffusion », s’ajoute la télévision sociale (Social TV). Avec un smartphone ou une tablette comme nouvelle télécommande, l’attention des mobinautes est retenue dans sa sphère amicale grâce à la possibilité de commenter et de partager un programme sur Twitter et Facebook, en prolongeant aussi longtemps que possible la « viralité » des contenus, avant, pendant et après la diffusion.

L’information cyberdépendante

En investissant dans des technologies qui ne leur appartiennent pas, et dont par ailleurs ils ne gèrent pas eux-mêmes les mécanismes ou les effets, les médias sont devenus cyberdépendants, s’éloignant peu à peu de leur mission de média de masse pour se conformer à une hyperindividualisation de la distribution des contenus en vogue sur le Web. A un rythme rapide, des innovations, petites ou grandes, naissent continuellement et influencent progressivement les médias, assurant la promotion d’un mode nouveau de « consommation » de l’information. Créant l’illusion d’un hyperchoix, la prolifération d’outils numériques contribue en réalité à enfermer chacun dans son cercle d’influence et de connaissances. Plus les internautes disposeront d’instruments qui retiennent leur attention sur les sujets qui les intéressent habituellement, moins ils seront disposés, par facilité et manque de temps, à aller chercher ailleurs, à découvrir autre chose que ce que les algorithmes leur proposent.

Ainsi, le réseau mondial, porteur d’une richesse infinie de contenus, est réduit à fournir à chacun les seuls contenus en adéquation avec ses centres d’intérêt déclarés en ligne, volontairement ou non. Cela reviendrait dans la vie réelle à se voir réserver à l’entrée d’une grande bibliothèque les seuls rayons des ouvrages correspondant à notre dernière lecture ou à celle de nos amis, à ne plus pouvoir choisir dans un kiosque à journaux que ceux des titres de presse qui s’apparentent à nos derniers achats. Sur les sites de vente en ligne, à l’instar du leader du marché Amazon, la pratique de la technique commerciale des ventes croisées (cross selling) grâce à laquelle l’internaute se voit suggérer des achats complémentaires, sous prétexte qu’ils ont été effectués par d’autres clients qui ont acquis le même produit que lui, contribue à généraliser le principe de la recommandation commerciale. Dans le même esprit, l’application Seesaw permet d’envoyer à ses amis les photos d’un objet que l’on hésite à acheter, afin de solliciter leur avis sur Twitter et sur Facebook avant de prendre une décision.

Cette « hyperindividualisation » de la distribution est construite par la plus grande régie publicitaire du monde, Google, et la plus grande plate-forme de promotion du monde, Facebook. Ces maîtres du marketing des usages numériques capitalisent l’attention des internautes, en amenant ces derniers à passer le plus de temps possible à utiliser leurs nombreux services internet. Grâce à la mine d’informations sur les attentes, les goûts, les habitudes, les affinités des internautes ainsi collectées, les grands groupes internet façonnent les usages sur le Web. L’information en ligne est gouvernée par les algorithmes des grands groupes internet qui en ordonnent la distribution selon leurs propres logiques. Chaque nouveau service est une occasion supplémentaire de contrôler le marché des contenus. Comme pour le secteur de la musique, récemment investi par Google et Twitter (voir supra), avec des services basés notamment sur la recommandation liée aux préférences des utilisateurs, les géants du Net sont parvenus à rendre la délivrance de l’information dépendante de leurs propres outils. Pour ces fabricants de logiciels et de matériels, l’information est un contenu comme un autre.

Les géants du Net ont insidieusement imposé la logique de la gratuité sur le réseau afin de capter pour eux-mêmes la quasi-totalité du marché publicitaire, sur lequel ils contribuent à maintenir des tarifs anormalement bas, sans rapport avec la notoriété des supports. Selon la logique de ciblage du « système internet », l’information en ligne n’est pas adressée indifféremment à tout le monde. Avec l’obsession de fournir le bon contenu, au bon moment, à la bonne audience, de cibler par conséquent la diffusion des contenus d’information à l’identique des messages publicitaires pour répondre à l’impératif d’audience, le paradoxe est le suivant : les médias traditionnels ou médias de masse n’informent plus un large public sur une variété de sujets, mais adressent à chacun les seuls thèmes qui sont censés l’intéresser. Comme dans le secteur de l’industrie, qui, pour sortir de la crise, invente des produits personnalisés, « customisés » ; les médias traditionnels s’allient aux groupes internet pour diffuser une information « sur mesure de masse » (mass customization), conforme aux caractéristiques et aux préférences de chaque internaute.

Sortir de sa bulle !…

Pour répondre à ce besoin vital de reconnaissance sur Internet, les médias disposent d’outils d’analyse de l’audience fournis pour la plupart par les groupes internet eux-mêmes. Les choix éditoriaux sont ainsi guidés, le plus souvent, par les statistiques de trafic sur le Web, nombre de visiteurs, de pages vues, de requêtes, articles les plus lus, les plus likés, les plus recommandés… L’analyse de données en temps réel de l’activité des internautes, page par page, sujet par sujet, minute par minute, y compris sur les réseaux sociaux, est un instrument de politique éditoriale, à l’instar de l’audimat pour la télévision. Quel journaliste ne surveille pas aujourd’hui le positionnement de son article dans Google Actualités ? Des outils de veille éditoriale permettent de scruter les sujets qui animent le Web comme Google Trends, palmarès instantané, par pays et par thème, des requêtes effectuées dans le moteur de recherche ou les « Tendances locales » de Twitter triées par pays ou par ville. Des méthodes d’analyse statistique sont capables de prévoir à l’avance quels seront les sujets « montants » sur les réseaux sociaux. Ces données de fréquentation en temps réel auront un impact de plus en plus grand sur la « production » et l’offre d’information.

La concurrence s’intensifie sur le marché de l’information en ligne, et l’influence des réseaux sociaux s’accroît. Se démarquer, sortir du buzz, ne pas aller inévitablement là où les autres vont, constitue pourtant un défi et une responsabilité pour les professionnels de l’information. A moins qu’à l’avenir et par souci d’économie, ils ne confient aux robots, sans plus d’intervention humaine, la collecte et la rédaction de « l’information qu’il nous faut ».