Le passage au tout-IA

« Éthique, transparence et contrôle » : de la politique à la pratique

Innover pour quel progrès ?

Des limites de l’automatisation aux limites à l’automatisation

Rien n’est « smart ». Tout est automatisé. Comme l’a écrit l’architecte Philippe Chiambaretta dans nos colonnes (La rem n°50-51, p.78), « le premier critère du qualificatif smart n’est pas la vertu ou l’intelligence, mais bien la rentabilité ! Ce qui est smart, c’est Apple [inventeur du smartphone, NDLR], dont la capitalisation boursière a franchi les 1 000 milliards de dollars ».

Dans de nombreux domaines et dans l’industrie en général, la délégation, de plus en plus fréquente, des tâches aux algorithmes apprenants (machine learning) se révèle incomparablement plus efficace, par sa rapidité et son faible coût, qu’une solution non automatisée. Pour autant les performances de l’IA s’appliqueraient-elles à toute activité ? La cohérence « artificielle » du modèle construit par la machine à partir du traitement et de l’analyse des données fournies rend-elle légitime, juste et acceptable la décision qui en découle ?

RIEN N’EST « SMART ». TOUT EST AUTOMATISé

Toutes les réalités peuvent-elles être confiées à la puissance de calcul d’une machine ? Autrement dit, comment sommes-nous passés de la reconnaissance de forme, outil indispensable à l’imagerie satellitaire par exemple, à la reconnaissance faciale aux portes des établissements scolaires (voir La rem n°52, p.106) ? En fait, l’IA est-elle forcément compatible avec tout, et surtout avec nous ? L’IA parvient-elle à quantifier nos contradictions, à modéliser l’irrationnel ? Pourquoi un homo numericus serait-il davantage emblématique qu’un homo economicus ? Enfin, les machines gagnant de plus en plus d’autonomie, qu’adviendra-t-il de la nôtre ?

Le passage au tout-IA

Alors que l’intelligence artificielle devient systémique, quels sont les garde-fous mis en place pour nous protéger de potentiels effets indésirables, ainsi que de ses conséquences indirectement néfastes, que l’on appelle des « externalités négatives ». Depuis longtemps, certaines activités, dont la finance, ne fonctionneraient pas sans elle.

TOUTES LES RéALITéS PEUVENT-ELLES êTRE CONFIéES à LA PUISSANCE DE CALCUL D’UNE MACHINE ?

À l’image d’un système financier international dont la faillite aurait des retentissements en cascade dramatiques – « Too big to fail » –, l’intelligence artificielle, qui a fini par envahir tous les secteurs économiques et sociaux, risquerait-t-elle à son tour d’être un rouage toxique qui sape nos sociétés et particulièrement nos libertés individuelles et collectives ? S’il existe une réglementation pour les banques systémiques, les fonds propres compensant en partie les risques pris, aucun cadre n’est prévu pour « stabiliser », le cas échéant, le développement de l’IA. Celle-ci déploie ses applications, sans contrainte, leur impact étant évalué a posteriori, car uniquement en cas de dommages. Le plus bel exemple reste l’affaire Cambridge Analytica, ce spécialiste du Big Data dont on ne mesurera jamais avec certitude le rôle dans l’élection de Donald Trump comme dans le vote du Brexit (voir La rem n°48, p.90). Le privacy paradox ne réside pas dans l’usage que les internautes font des réseaux sociaux (La rem n°46-47, p.51) mais bien dans le secret des boîtes noires opérant des services en ligne qui prospèrent sur nos vies à livre ouvert.

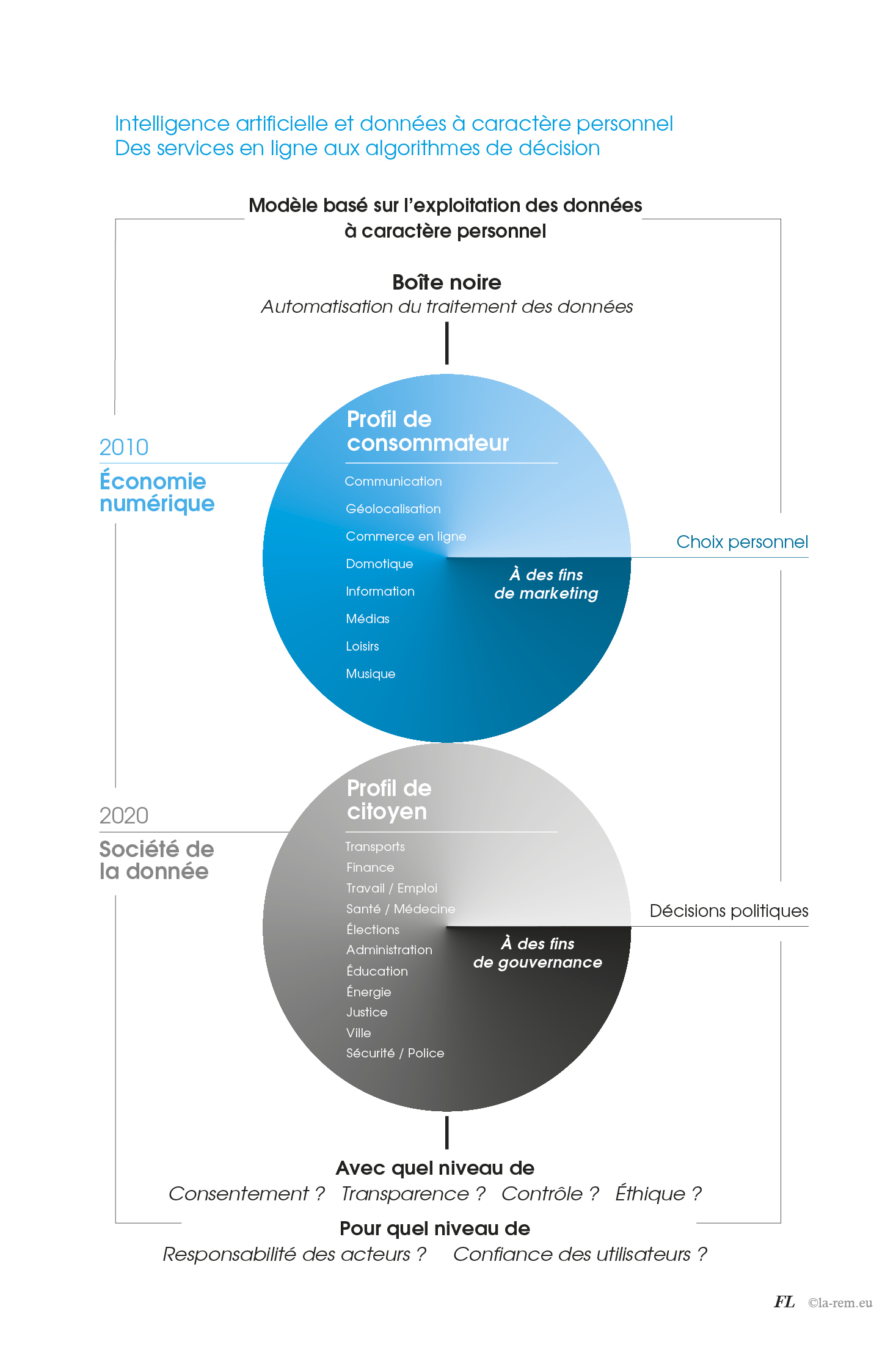

Quelles données sont soumises à quel traitement, et pour quel résultat ? Des questions qui ne semblaient pas revêtir une « importance systémique » tant qu’il s’agissait d’écouter de la musique en ligne, de faire une recherche sur internet ou encore de poster une photo sur un réseau social. L’enjeu n’avait alors pas plus d’importance qu’un message publicitaire de trop. Mais peu à peu, les avancées de l’IA ont nourri le commerce des données personnelles. Les algorithmes de décision s’appliquent désormais à la justice, à la santé, à l’éducation, à la ville, aux transports, à la sécurité, etc. En abolissant les distances et le temps de nos communications, l’internet nous avait fait basculer dans une nouvelle forme de progrès. En offrant des performances inédites, l’IA omnisciente ouvre une nouvelle ère, l’ère de l’automatisation des décisions, c’est-à-dire l’automatisation des choix, bel oxymore. Nous avons accepté sans plus de questions ou de craintes la banalisation de l’exploitation de nos données personnelles à des fins commerciales, nous laisserons-nous conduire, déjà résignés, dans le nouveau monde de l’IA ? Avec à la clé, un autre paradoxe, et non des moindres : accorder notre confiance aux acteurs de l’IA qui auront fait, en gage de loyauté, le serment de la transparence, pourtant sans garantie a priori sur les critères de choix opérés par des machines qui sont auto-apprenantes.

L’arsenal numérique à venir est le déploiement tous azimuts d’applications d’intelligence artificielle basées sur le traitement de données à grande échelle. L’IA est devenue un mode de régulation à part entière. L’IA s’impose partout et il est difficile d’en interroger les conséquences sans paraître technophobe aux yeux d’autrui. Des questions n’en demeurent-elles pas moins légitimes, ou au minimum, logiques ? Sur le marché du travail, l’IA joue au DRH, avec des entretiens d’embauche en vidéo, ou bien au contremaître en rythmant le travail au sein des entrepôts d’Amazon, ou encore en encourageant l’hypermobilité des cadres.

L’IA OMNISCIENTE OUVRE UNE NOUVELLE èRE, L’èRE DE L’AUTOMATISATION DES DéCISIONS, C’EST-à-DIRE L’AUTOMATISATION DES CHOIX, BEL OXYMORE

Tout a commencé avec la proposition d’outils aussi serviables que salutaires et gratuits. L’économie numérique est née du succès remporté par des services en ligne novateurs, elle s’est ensuite renforcée, grâce à la performance des terminaux, avec la migration des usages de l’ordinateur vers le smartphone. Ont été radicalement « numérisés » nos modes de communication, puis nos modes de consommation de l’information, des loisirs, des biens culturels, pour arriver à la banalisation totale du commerce électronique. Une décennie plus tard, cette révolution technologique a ouvert la voie à une véritable mutation numérique de la société. Sur les fondements de l’économie en ligne se met en place un nouveau modèle de société – une société de la donnée. Au sein de celle-ci, tous les services, y compris les services non commerciaux, fonctionnent ou fonctionneront à terme grâce à l’exploitation des données à caractère personnel. En 2010, l’économie numérique dessinait des profils de consommateurs, à des fins de marketing et par choix personnel : il était encore possible d’y renoncer. En 2020, la société de la donnée établit des profils de citoyens, à des fins de gouvernance, résultats de décisions politiques qui s’imposent.

DéVELOPPER UNE SOCIéTé DE LA DONNéE « à L’EUROPéENNE », AFFRANCHIE DES GUIDELINES DES GAFAM ET AUTRES SYSTèMES PROPRIÉTAIRES

Fascinant par leur capitalisation boursière, imposant des rêves de licornes, cinq acteurs américains, les Gafam, inventeurs des plateformes de services à volonté, se sont saisis d’un pouvoir exorbitant. Ces groupes à l’envergure mondiale ont une ascendance sans précédent sur la façon dont les humains communiquent, s’informent, se distraient, consomment ou se déplacent. Généralement, leurs outils numériques, au travail ou à l’école, ont été adoptés spontanément, sans a priori et le plus souvent sans même se donner la peine d’en mesurer a posteriori les effets. Pas loin de dix ans après leur « coup d’État », un cadre protecteur a été instauré en Europe, le RGPD (Règlement général sur la protection des données), mais ce règlement ne peut briser ni les habitudes ni les parts de marché fortement consolidées. Sans coup férir, l’Europe a cédé sa place au sein de l’économie numérique, tant pour les services que pour les terminaux. Face à l’ampleur du phénomène IA, quels seront les moyens mis en œuvre pour développer une société de la donnée « à l’européenne », affranchie des guidelines des Gafam et autres systèmes propriétaires ? Les biais, les travers, les risques et autres dangers d’une IA débridée ont déjà été maintes fois dénoncés (voir La rem n°50-51, p.40 et p.45).

Il faut donc réguler, certes. Instaurer de bonnes pratiques, évidemment. Mais sur quels critères ? Définis par quelle instance ? L’expérience de la mairie de New York est édifiante. Après avoir constitué, en décembre 2017, un groupe de travail consacré à l’encadrement des systèmes de traitement automatisé déployés dans la ville – de la sectorisation scolaire au ramassage des ordures ménagères –, un poste de responsable des politiques algorithmiques a été créé au sein de la mairie. En 2019, les protagonistes reconnaissent l’échec de leur initiative, principalement en raison du manque d’informations, lié aux secrets commerciaux protégeant les technologies propriétaires utilisées par les fournisseurs de services de la ville. Selon les professeurs de l’université de Berkeley, Deidre Mulligan et Kenneth Bamberger, cités par le blog InternetActu.net, « le risque est de laisser les décisions de conception aux services privés et d’abdiquer la responsabilité des acteurs publics, ainsi que la participation des citoyens dans l’élaboration des politiques publiques ». Ils ajoutent que la conception choisie doit être « contestable », c’est-à-dire que ses caractéristiques et ses paramètres seront communiqués afin d’être contrôlables et éventuellement modifiés.

Il faut donc réguler, certes. Instaurer de bonnes pratiques, évidemment. Mais sur quels critères ? Définis par quelle instance ? L’expérience de la mairie de New York est édifiante. Après avoir constitué, en décembre 2017, un groupe de travail consacré à l’encadrement des systèmes de traitement automatisé déployés dans la ville – de la sectorisation scolaire au ramassage des ordures ménagères –, un poste de responsable des politiques algorithmiques a été créé au sein de la mairie. En 2019, les protagonistes reconnaissent l’échec de leur initiative, principalement en raison du manque d’informations, lié aux secrets commerciaux protégeant les technologies propriétaires utilisées par les fournisseurs de services de la ville. Selon les professeurs de l’université de Berkeley, Deidre Mulligan et Kenneth Bamberger, cités par le blog InternetActu.net, « le risque est de laisser les décisions de conception aux services privés et d’abdiquer la responsabilité des acteurs publics, ainsi que la participation des citoyens dans l’élaboration des politiques publiques ». Ils ajoutent que la conception choisie doit être « contestable », c’est-à-dire que ses caractéristiques et ses paramètres seront communiqués afin d’être contrôlables et éventuellement modifiés.

« Éthique, transparence et contrôle » : de la politique à la pratique

« Je tiens à ce que cette Europe numérique reflète le meilleur de notre continent : l’ouverture, l’équité, la diversité, la démocratie et la confiance », a déclaré Ursula von der Leyen, présidente de la Commission européenne. Afin « de façonner l’avenir numérique de l’Europe », Bruxelles a présenté, le 19 février 2020, son Livre blanc sur l’intelligence artificielle, préambule au prochain cadre réglementaire en prévision duquel une consultation de l’ensemble des acteurs concernés est ouverte jusqu’au 19 mai 2020. La Commission annonce construire « une société européenne soutenue par des solutions numériques qui placent les citoyens au premier plan, ouvrent de nouvelles perspectives aux entreprises et encouragent le développement de technologies fiables pour promouvoir une société ouverte et démocratique et une économie dynamique et durable ». Trois axes sont définis pour les cinq prochaines années : « la technologie au service des personnes », « une économie juste et compétitive » et « une société ouverte, démocratique et durable ». « Afin d’instaurer un climat de confiance », l’IA devra être appliquée « de manière éthique, responsable et en ligne avec nos valeurs et avec le règlement général pour la protection des données (RGPD) », selon les propos du commissaire européen, responsable du marché intérieur, Thierry Breton. Pour ce faire, il conviendra de distinguer les applications sans risque et les applications critiques, celles qui concernent, entre autres, les secteurs de la santé et de la médecine, les transports ou la police. Ces dernières seraient soumises à une validation a priori, suivie de contrôles a posteriori.

LES PROMESSES DE L’IA SUFFIRONT-ELLES à JUSTIFIER LA GéNéRALISATION DE SON APPLICATION ?

Quant à la reconnaissance faciale, Bruxelles mettra en place un moratoire avant de l’autoriser. Un nouveau règlement européen sur la gouvernance des données sera établi, encourageant à la fois leur accessibilité et leur partage entre acteurs. La Commission européenne ambitionne de créer un « marché unique européen des données », le stockage et le traitement de celles-ci profitant aux entreprises européennes. Grâce à un fonds de soutien à l’innovation de 100 millions d’euros, la Commission espère, en combinant des financements publics et privés, mobiliser 20 milliards d’euros, afin d’accélérer le déploiement de l’IA, y compris au sein des petites et moyennes entreprises.

Les promesses de l’IA telles que les diagnostics médicaux ou la voiture autonome suffiront-elles à justifier la généralisation de son application ? La stratégie de la Commission européenne répondra-t-elle aux inquiétudes exprimées quant aux boîtes noires des algorithmes, aux robots qui remplacent les humains, à l’explosion des objets connectés ? Pour l’heure, la décision de reporter l’autorisation de l’usage des techniques de reconnaissance faciale par des acteurs publics ou privés dans les espaces publics signe l’arrêt des projets en cours en France. Le 20 janvier 2020, l’association La Quadrature du Net et la Ligue des droits de l’homme ont déposé un recours en référé devant le tribunal administratif de Marseille, afin de faire annuler la décision d’équiper la ville d’une « vidéoprotection intelligente ». En Allemagne, le gouvernement a finalement renoncé, en janvier 2020, à autoriser la police fédérale à recourir à la reconnaissance faciale, et ce, malgré les bons résultats de l’expérimentation menée dans la gare de Berlin de Südkreuz avec un taux d’erreur de 0,1 %.

Outre-Atlantique, les promoteurs de la reconnaissance faciale eux-mêmes cherchent à se protéger. Patron de Google, Sundar Pichai explique dans les colonnes du Financial Times le 20 janvier 2020 : « Il y a de réelles inquiétudes concernant les potentielles conséquences négatives de l’IA, des deepfakes jusqu’aux utilisations néfastes de la reconnaissance faciale. […] Des entreprises comme la nôtre ne peuvent pas élaborer des nouvelles technologies prometteuses et laisser les forces du marché décider comment celle-ci [l’IA] va être utilisée. » De telles précautions n’ont pas toujours été prises.

« DES ENTREPRISES COMME LA NôTRE NE PEUVENT PAS éLABORER DES NOUVELLES TECHNOLOGIES PROMETTEUSES ET LAISSER LES FORCES DU MARCHé DéCIDER COMMENT CELLE-CI [L’IA] VA êTRE UTILISéE » Sundar Pichai, patron de Google

Innover pour quel progrès ?

Révélé par une longue enquête du New York Times publiée le 18 janvier 2020, le scandale de l’activité de Clearview AI y est sans doute pour quelque chose. Avec une base de données de plus de trois milliards d’individus, constituée à partir des photographies postées sur les réseaux sociaux, l’entreprise américaine propose une application de reconnaissance faciale, faisant correspondre un visage à des photos et informations en ligne. Clearview AI compte 600 clients parmi des services de police aux États-Unis, dont le FBI, et au Canada, ainsi que des entreprises privées de sécurité. « Les utilisateurs de Clearview peuvent potentiellement identifier de la sorte toutes les personnes qu’elles ont vues », écrit le New York Times traduit par Le Monde, et connaître ainsi, outre leur identité, leurs amis, leurs activités, leur lieu de vie, leurs habitudes. Clearview a reçu le soutien financier de Peter Thiel, fondateur de Palantir. Quand la promesse de gains attire des apprentis sorciers de l’innovation, l’IA devient un outil dangereux. Selon une étude du National Institute of Standards and Technology (NIST), organisme rattaché au gouvernement, les algorithmes de reconnaissance faciale développés aux États-Unis se trompent davantage que ceux construits en Asie, avec 100 fois plus d’erreurs pour l’identification de personnes asiatiques ou noires que pour des personnes blanches.

COMPAS, CET OUTIL QUI DOIT AIDER LE JUGE, S’EST RéVéLé PARTICULIèREMENT « RACISTE »

Identifiés et décriés, les biais discriminants des algorithmes ont la vie dure. En novembre 2019, le département des services financiers de l’État de New York a ouvert une enquête, impliquant Apple et la banque Goldman Sachs, à la suite des accusations de discrimination sexiste portées à leur encontre par un entrepreneur américain. Ce client du moyen de paiement Apple Card s’est indigné de l’absence totale d’explications, de la part du groupe Apple, concernant la décision de la machine d’accorder à sa femme, malgré leur compte commun, une limite de crédit 20 fois inférieure à la sienne. Même « en deep learning », la sagacité de l’IA ne peut outrepasser les critères instaurés par ceux qui l’ont programmée.

Le risque de biais porte sur les domaines les plus sensibles des sociétés démocratiques comme la justice prédictive, déjà expérimentée aux États-Unis. Développé par l’entreprise Northpointe, COMPAS – Correctional Offender Management Profiling for Alternative Sanctions – est un algorithme qui calcule, notamment à partir de ses réponses à une centaine de questions, la probabilité de récidive d’un condamné. Cet outil, qui doit aider le juge à prendre la décision d’accorder ou pas une libération conditionnelle, s’est révélé particulièrement « raciste », en attribuant un taux de récidive potentielle deux fois supérieur aux Afro-américains comparés aux autres populations, dont les Blancs pour lesquels le risque est au contraire sous-estimé.

Les applications de l’IA mises en doute s’étendent également aux procédures de recrutement vidéo auxquelles la plupart des grands groupes ont recours. « Il n’y a aucune base scientifique dans la démarche. Et personne ne sait vraiment comment l’algorithme fonctionne et trie les candidats », explique Matthias Spielkamp, directeur de l’ONG allemande Algorithm Watch, au sujet du dispositif de prérecrutement, vendu par la société américaine HireVue, qui associe données biométriques et reconnaissance faciale. Aux États-Unis, HireVue compte plus de 770 entreprises clientes, un tiers de celles classées au Fortune 100. Publiée en novembre 2019, une étude réalisée par le sociologue Jean-François Amadieu, professeur à l’université Paris 1, révèle « qu’une préoccupante évolution des techniques de recrutement est en train de se produire : recruter en s’appuyant sur de mystérieux algorithmes qui analysent non seulement le contenu verbal mais aussi la voix, les gestes et le visage des candidats ayant passé des entretiens vidéo ». Entreprise leader du secteur en France, Easyrecrue commercialise ses logiciels auprès de 70 % des entreprises du CAC 40.

« UNE PRéOCCUPANTE éVOLUTION DES TECHNIQUES DE RECRUTEMENT EST EN TRAIN DE SE PRODUIRE » Jean-François Amadieu, professeur à l’université Paris 1

Ce n’est pas le fait d’automatiser les recrutements qui pose problème pour Jean-François Amadieu, qui considère qu’un logiciel peut être « moins subjectif et discriminant » qu’un recruteur, mais « priver les candidats de pouvoir poursuivre les étapes de sélection après avoir regardé une vidéo de quelques secondes est consternant ». En outre, le sociologue pointe l’aberration qui consiste à pratiquer l’analyse faciale via un algorithme alors que celle-ci est interdite dans le cadre d’un recrutement traditionnel.

Institut de recherche interdisciplinaire de l’université de New York, fondé en 2017 par Kate Crawford et Meredith Whittaker, AI Now Institute est consacré à l’étude des implications sociales des technologies d’intelligence artificielle. Dans l’édition 2019 de leur rapport, les chercheurs américains écrivent : « Il apparaît clairement que, dans divers domaines et contextes, l’IA accroît les inégalités, en plaçant l’information et le contrôle entre les mains de ceux qui ont déjà le pouvoir et en privant encore plus ceux qui ne l’ont pas. » Constatant notamment l’accélération rapide des systèmes algorithmiques contrôlant tout dans le milieu du travail, ils dénoncent le fait que « dans les entrepôts de traitement des commandes d’Amazon, au volant d’un Uber ou lors des entretiens d’embauche pour leur premier emploi à la sortie de l’université, les travailleurs sont de plus en plus souvent gérés par l’IA, avec peu de protections ou de garanties ». Parmi les recommandations formulées par l’équipe d’AI Now, figure l’interdiction de l’usage de la reconnaissance des affects pour juger de toute décision importante dans la vie : entretiens d’embauche, fixation de la prime d’assurance, évaluation de la douleur d’un patient ou résultats scolaires. On retiendra également la recommandation d’accorder, aux travailleurs du secteur des technologies, un droit de savoir ce qu’ils construisent et de contester, le cas échéant, les utilisations nuisibles de leur travail.

UNE DéCISION, RéSULTANT DU BRASSAGE DE DONNéES STATISTIQUES, PEUT-ELLE êTRE éTHIQUE ?

Une décision, résultant du brassage de données statistiques, peut-elle être éthique ? Concernant la prédiction de la capacité d’une personne à rembourser un emprunt en fonction de son lieu de résidence, Martin Gibert, philosophe et chercheur en éthique de l’IA à l’université de Montréal répond : « Est-ce que, en tant que société, on accepte que l’IA puisse influencer une décision en fonction de là où on habite ? L’IA dans ce cas-là nous oblige à statuer s’il est moralement acceptable que le quartier d’où l’on provient conditionne que l’on obtienne un prêt bancaire ou pas. C’est une question qui était nettement moins présente avant que l’on ait toutes ces données massives qui permettent de tirer ce genre de conclusions. Mais dire que c’est éthique ou non pour ce type de décision est très difficile, je ne peux pas répondre. »

S’inspirant de l’Observatoire international sur les impacts sociétaux de l’intelligence artificielle et du numérique (OBVIA) de l’université de Laval au Québec, l’université Côte d’Azur, la Chambre de commerce et de l’industrie, le département et la Communauté d’agglomération Sophia Antipolis (CASA) ont inauguré, en novembre 2019, le premier observatoire français de l’IA. Baptisé OTESIA – Observatoire des impacts technologiques économiques et sociétaux de l’intelligence artificielle –, cet organisme a pour mission de promouvoir « une intelligence artificielle responsable et éthique, où l’humain est au cœur des réflexions ». Ses travaux s’orienteront autour de thématiques comme l’éducation, la santé, le bien-vieillir et l’environnement. Initiative unique en France et en Europe, Otesia entend notamment « réfléchir aux conséquences de l’IA sur les nouveaux métiers, les nouveaux comportements, les nouveaux usages ; participer à la construction d’une véritable déontologie autour de l’IA ; aider et appuyer les décisions des politiques publiques en incluant l’IA de façon réfléchie, observer l’usage de l’IA dans les entreprises et labéliser les actions les plus vertueuses ». Le québécois OBVIA et le français OTESIA ont signé la Déclaration de Montréal pour le développement responsable de l’intelligence artificielle, adoptée en 2018.

Des limites de l’automatisation aux limites à l’automatisation

Se focaliser sur la perfectibilité des algorithmes, est-ce le bon combat ? À propos de l’accident mortel impliquant une voiture autonome d’Uber en mars 2018, la technologie « ne prenait pas en compte l’éventualité de piétons traversant hors des clous » a indiqué le régulateur américain des transports NTSB dans un rapport publié en novembre 2019. Et d’ajouter concernant la femme de 49 ans qui a été tuée : « Le système ne l’a jamais classée comme « piétonne » mais comme « objet » ». Aux États-Unis, « pour un emploi créé par Amazon, deux disparaissent ». Quelle est la bonne mesure ? Dans le nouveau monde de l’IA, en cours de normalisation, la barre devra être placée très haut, non pas en visant les sommets de la capitalisation boursière des Gafam, mais plutôt à une hauteur qui semble jusqu’ici plus compliquée à atteindre, à hauteur d’homme – du choix humain, tel Bartelby et son « I would prefer not to ».

Sources :

- « La carte de paiement d’Apple accusée d’être sexiste », AFP,

tv5monde.com, 10 novembre 2019. - « Les mouvements des yeux peuvent-ils fonder la décision d’embauche ? », Anne Rodier, 28 novembre 2019.

- « Lancement de l’OTESIA, 1er observatoire sur l’Intelligence artificielle en France et en Europe », Université Côte d’Azur, univ-cotedazur.fr, 29 novembre 2019.

- « De la difficulté à imposer la transparence des décisions automatisées », Hubert Guillaud, internetactu.net, 13 décembre 2019.

- « Quelle éthique pour l’intelligence artificielle ? », entretien avec Martin Gibert, chercheur en éthique de l’intelligence artificielle à l’université de Montréal, Pascal Hérard, TV5monde.com, 20 décembre 2019.

- « La reconnaissance faciale est loin d’être fiable », Claude Fouquet, Les Echos, 23 décembre 2019.

- AI Now 2019 Report, AI Now Institute, ainowinstitute.org, December 2019.

- « Bruxelles envisage d’interdire provisoirement la reconnaissance faciale », Samuel Stolton, Euractiv.com, 20 janvier 2020.

- « Reconnaissance faciale : une start-up analyse les photos des réseaux sociaux pour la police américaine », lemonde.fr, 20 janvier 2020.

- « La police de Berlin renonce à la reconnaissance faciale », Luc André, L’Opinion, 28 janvier 2020.

- « Le commissaire européen Thierry Breton lève le voile sur la communication de la Commission européenne sur la 5G », La Correspondance de la Presse, 29 janvier 2020.

- « Intelligence artificielle : l’UE peaufine sa stratégie », Cédric Vallet, Le Monde, 10 février 2020.

- « Façonner l’avenir numérique de l’Europe : la Commission présente des stratégies en matière de données et d’intelligence artificielle », communiqué de presse, Commission européenne, ec.europa.eu, 19 février 2020.

- Intelligence artificielle. Une approche européenne axée sur l’excellence et la confiance, Livre blanc, Commission européenne, ec.europa.eu, 19 février 2020.